[ad_1]

Untuk semua yang dapat dicapai oleh jaringan saraf, kami masih belum benar-benar memahami bagaimana mereka beroperasi. Tentu, kita dapat memprogramnya untuk dipelajari, tetapi memahami proses pengambilan keputusan mesin tetap seperti teka-teki mewah dengan pola rumit yang memusingkan di mana banyak bagian integral yang belum dipasang.

Jika sebuah model mencoba untuk mengklasifikasikan gambar teka-teki tersebut, misalnya, ia dapat menghadapi serangan permusuhan yang terkenal, tetapi mengganggu, atau bahkan lebih banyak masalah data atau pemrosesan run-of-the-mill. Tetapi jenis kegagalan baru yang lebih halus yang baru-baru ini diidentifikasi oleh para ilmuwan MIT adalah penyebab lain yang perlu dikhawatirkan: “overinterpretasi,” di mana algoritme membuat prediksi yang meyakinkan berdasarkan detail yang tidak masuk akal bagi manusia, seperti pola acak atau batas gambar.

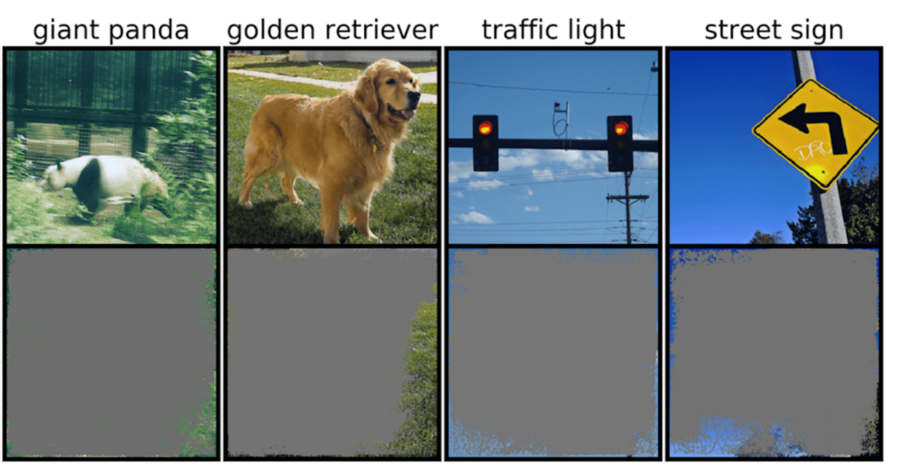

Keterangan: Pengklasifikasi gambar dalam dapat menentukan kelas gambar dengan kepercayaan lebih dari 90 persen menggunakan batas gambar utama, bukan objek itu sendiri. Kredit gambar: Rachel Gordon

Ini bisa sangat mengkhawatirkan untuk lingkungan berisiko tinggi, seperti keputusan sepersekian detik untuk mobil self-driving, dan diagnosa medis untuk penyakit yang membutuhkan perhatian lebih segera. Kendaraan otonom khususnya sangat bergantung pada sistem yang dapat secara akurat memahami lingkungan dan kemudian membuat keputusan yang cepat dan aman. Jaringan tersebut menggunakan latar belakang, tepi, atau pola langit tertentu untuk mengklasifikasikan lampu lalu lintas dan rambu jalan — terlepas dari apa pun yang ada di gambar.

Tim menemukan bahwa jaringan saraf yang dilatih pada kumpulan data populer seperti CIFAR-10 dan ImageNet mengalami interpretasi yang berlebihan. Model yang dilatih dengan CIFAR-10, misalnya, membuat prediksi yang meyakinkan bahkan ketika 95 persen gambar input hilang, dan sisanya tidak masuk akal bagi manusia.

“Penafsiran yang berlebihan adalah masalah kumpulan data yang disebabkan oleh sinyal tidak masuk akal ini dalam kumpulan data. Tidak hanya gambar kepercayaan tinggi ini tidak dapat dikenali, tetapi juga mengandung kurang dari 10 persen gambar asli di area yang tidak penting, seperti perbatasan. Kami menemukan bahwa gambar-gambar ini tidak ada artinya bagi manusia, namun model masih dapat mengklasifikasikannya dengan keyakinan tinggi, ”kata Brandon Carter, mahasiswa PhD Laboratorium Ilmu Komputer dan Kecerdasan Buatan MIT dan penulis utama di sebuah kertas tentang penelitian.

Pengklasifikasi gambar dalam banyak digunakan. Selain diagnosis medis dan peningkatan teknologi kendaraan otonom, ada kasus penggunaan dalam keamanan, permainan, dan bahkan aplikasi yang memberi tahu Anda apakah ada sesuatu yang hot dog atau bukan, karena terkadang kita perlu diyakinkan. Teknologi dalam diskusi bekerja dengan memproses piksel individu dari berton-ton gambar pra-label untuk jaringan untuk “belajar.”

Klasifikasi gambar sulit dilakukan, karena model pembelajaran mesin memiliki kemampuan untuk menangkap sinyal halus yang tidak masuk akal ini. Kemudian, ketika pengklasifikasi gambar dilatih pada kumpulan data seperti ImageNet, mereka dapat membuat prediksi yang tampaknya andal berdasarkan sinyal tersebut.

Meskipun sinyal yang tidak masuk akal ini dapat menyebabkan kerapuhan model di dunia nyata, sinyal tersebut sebenarnya valid dalam kumpulan data, artinya interpretasi yang berlebihan tidak dapat didiagnosis menggunakan metode evaluasi tipikal berdasarkan akurasi tersebut.

Untuk menemukan alasan prediksi model pada input tertentu, metode dalam penelitian ini dimulai dengan gambar penuh dan berulang kali bertanya, apa yang dapat saya hapus dari gambar ini? Pada dasarnya, itu terus menutupi gambar, sampai Anda memiliki bagian terkecil yang masih membuat keputusan dengan percaya diri.

Untuk itu, dimungkinkan juga untuk menggunakan metode ini sebagai jenis kriteria validasi. Misalnya, jika Anda memiliki mobil yang mengemudi secara mandiri yang menggunakan metode pembelajaran mesin terlatih untuk mengenali rambu berhenti, Anda dapat menguji metode tersebut dengan mengidentifikasi subset input terkecil yang membentuk rambu berhenti. Jika itu terdiri dari cabang pohon, waktu tertentu dalam sehari, atau sesuatu yang bukan merupakan tanda berhenti, Anda mungkin khawatir mobil akan berhenti di tempat yang tidak seharusnya.

Meskipun tampaknya model adalah penyebab yang mungkin terjadi di sini, kumpulan data lebih cenderung disalahkan. “Ada pertanyaan tentang bagaimana kita dapat memodifikasi kumpulan data dengan cara yang memungkinkan model dilatih untuk meniru lebih dekat bagaimana manusia akan berpikir tentang mengklasifikasikan gambar dan oleh karena itu, mudah-mudahan, menggeneralisasi lebih baik dalam skenario dunia nyata ini, seperti mengemudi otonom. dan diagnosis medis, sehingga model tidak memiliki perilaku tidak masuk akal ini,” kata Carter.

Ini mungkin berarti membuat kumpulan data di lingkungan yang lebih terkontrol. Saat ini, hanya gambar yang diambil dari domain publik yang kemudian diklasifikasikan. Tetapi jika Anda ingin melakukan identifikasi objek, misalnya, mungkin perlu melatih model dengan objek dengan latar belakang yang tidak informatif.

Ditulis oleh Rachel Gordon

Sumber: Institut Teknologi Massachusetts

[ad_2]